好股友在 DeepMind 首席研究科学家、伦敦大学学院计算机科学教授David Silver 看来,游戏是激发创造力的关键,尤其是对AI而言。

Silver曾小时候参加过全国拼字游戏比赛,之后他继续在剑桥学习并共同创办了一家视频游戏公司。

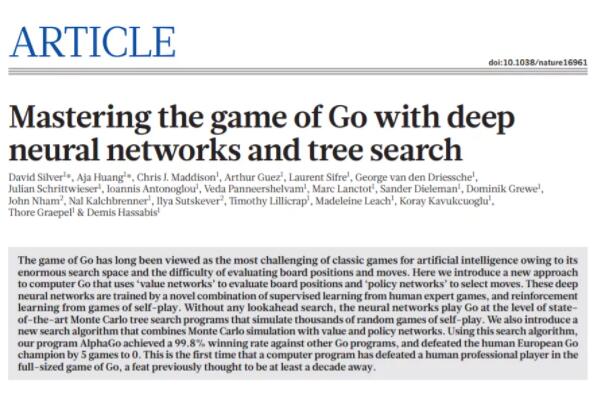

后来,在获得人工智能博士学位后,他带领DeepMind团队开发了 AlphaGo,这是第一个围棋比赛中击败世界冠军的AI程序。

对于Silver 来说,游戏是了解人类和人工大脑如何自行学习以实现目标的实验场。

对于围棋AI AlphaGo来说,向程序提供有关人类在不同位置的决策,再让AI模仿,这种学习被称为「监督式学习」。实现AI程序通过自对弈中学习,这种方式称为「强化学习」。

然后,在 AlphaGo 和世界冠军的关键比赛中,Silver突然想到:也许,机器的决策根本不应该受到人类的影响。

这个想法最终成为 AlphaGo Zero 的开端,它是 AlphaGo 的继任者,在完全不接收人类知识的情况下,只靠强化学习,从游戏规则出发学习如何下好围棋。

后来,AlphaGo Zero 与 AlphaGo 对弈 100 局,零封了自己的「老大哥」。

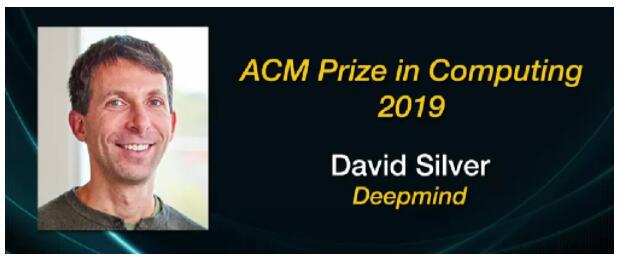

2020年4月,David Silver因在「计算机游戏方面的突破性进步」获得了2019年ACM计算奖。

在颁奖仪式上,时任ACM主席 Cherri M. Pancake表示:

「很少有其他研究人员像 David Silver 那样,在 AI 领域引起如此多的令人兴奋的成果。他对深度强化学习的见解已经从游戏中铺开,应用于多个领域,包括电网效率的提升、降低数据中心的功耗以及为欧洲航天局规划太空探测器的轨迹等。」

另外,Silver是英国皇家学会Fellow,也是在AI领域首位获得门萨基金最佳科学发现奖的科学家。

Silver的明星气质与他安静、谦逊的天性形成鲜明对比。在本次采访中,Silver 谈论了游戏、创造力的意义,以及AI在避免气候变化、病原体感染、大规模贫困和环境灾难等方面的应用潜力。

以下是访谈内容:

你小时候玩游戏的方式就与其他孩子不一样吗?

我那时候参加过全国学校拼字游戏比赛,我还记得一些有趣的时刻。

有一次,在最后一场比赛结束时,我问我的对手,「你确定要拼这个词吗?为什么不拼一个得分更高的词呢?」 他改变了自己的拼法,赢得了比赛和冠军,这让我非常高兴。

比起赢得比赛,我更着迷于比好一场比赛的意义。

您是如何将对游戏的热爱转化为一份真正的工作的?

后来,我接触到了国际象棋,遇到了Demis Hassabis(DeepMind 的联合创始人 。那个时候,他是世界上同龄最强的少年棋手。

当时他零花钱不够时,就会来我所在的镇里,参加比赛,赢走 50 英镑的奖金,然后回家。后来,我们在剑桥认识了,并一起成立了一家游戏公司 Elixir,现在我们一起回到了 DeepMind。

这种对游戏的迷恋,教会了你解决问题的哪些方面?

一方面,我们相信自己拥有所谓「创造力」的特殊能力,而AI算法并没有这种能力。实际上这是一个谬论。

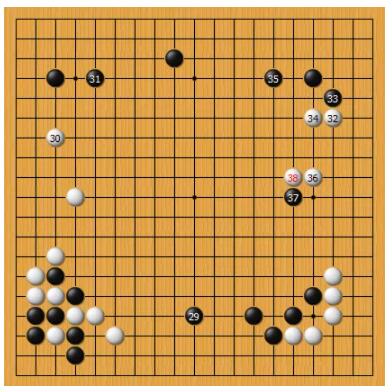

现在,在 AI 中已经看到了创造力的端倪。2016年 AlphaGo 对阵李世石的第二局比赛中,AlphaGo执黑下出的第37手,围棋社区中就认为创造力十足,甚至超出了当时人类职业棋手的理解。这说明,AI的确尝试了一些非同以往的新东西。

但是,人类可以将这种广泛的创造力应用于任何事物,而不仅仅是在游戏中吗?

整个试错学习的过程,比如尝试自己去想办法,或者让AI自己去想办法,如何解决问题,这都是一个创造性的过程。AI从一开始什么都不知道。然后会发现一件新事物、一种创造性飞跃、一种新模式或一种新想法,这有助于比以前更好地实现目标。

现在,你掌握了玩游戏、解谜或与人互动的新方式。这个过程实际上是成千上万个小发现一个接一个累计而成的。这才是「创造力」的本质。

如果AI算法没有创造力,就会陷入困境。AI需要有能力为自己尝试新的想法——那些人类没有告诉它们的想法。这应该是未来研究的方向,以继续推动通过自我尝试得出「新点子」的系统。

许多人认为,计算机只能在人类业余水平上下围棋。你有没有怀疑过自己进步的能力?

当我参加 2016 年 AlphaGo 比赛抵达韩国时,看到了一排排的摄像头,我听说当时有超过 2 亿人在网上观看,我想当时想「等等,这真的能行吗?」

对手李世乭是一位天才的世界冠军,他会尝试一切手段,将AI程序带入一般不会发生的奇怪情况。

我感到很幸运,我们经受住了那次考验。后来我问自己:“能不能退一步回到基础,理解一个系统真正为自己学习意味着什么?” 为了找到更纯粹的东西,我们放弃了AI模型中的人类知识,开发出了 AlphaZero。

几千年来,人类已经为围棋制定了众所周知的策略。当 AlphaZero 迅速发现并拒绝了这些有利的策略时,您是怎么想的?

我们设置了原版 AlphaGo 下错的位置(与人类职业选手相比)。我们认为,如果能找到一个让AI自己找到正确位置的新版本,就算是成功了。一开始,我们取得了巨大的进步,但后来似乎就不行了。我们认为AI并没有自己找到正确的 20 到 30 手的位置。

与我们合作的职业选手樊麾花了几个小时研究这些着法。最后他说,是职业选手下错了,AlphaZero 是对的。AI找到了解决方案,重新评估了最初被归于「错误」的棋。我意识到我们有能力推翻人类认为的标准知识。

这之后,你主持开发AlphaStar,让AI玩《星际争霸2》。为什么从围棋跳到了电子游戏?

围棋是一个相对狭小的领域。要想从围棋入手,扩展到人脑的能力范围需要大量的步骤。我们尝试更复杂的维度,那些人类做得好,但AI做不好的大量领域。

从AlphaGo到AlphaStar, 实际上是个自然的发展。与人类一样,AI系统只能看见地图的某个部分。这就不像下围棋或国际象棋,能看到对手和自己的所有棋子。游戏中只能看到控制对象附近的信息,你必须侦察以获取信息。这更接近现实世界中发生的事情。

最终目标是什么?

我认为AI代理的能力与人类大脑一样广。虽然目前我们还不知道如何才能完全实现大脑的功能,但在人脑中有存在的证据。

完全复制人脑吗?你真的认为这很现实吗?

我不相信对大脑的神奇、神秘的解释。

在某种程度上,人脑是一种算法,它以强大而通用的方式接受输入并产生输出。我们理解和构建人工智能的能力有限,但这种理解正在快速增长。今天,我们拥有能够破解了围棋等狭窄领域的AI,也有了可以理解和产生自然语言的模型。

那么,你认为人AI的能力没有上限吗?

现在我们才刚刚开始上路。想象一下,如果再经历 40 亿年的进化,我们会是什么状态?也许我们会拥有更复杂的智能,可以做得更好。AI和这有点像,这个过程没有限制,因为世界在本质上是无限复杂的。

那么,会有上限吗?在某些时候,物理极限的确存在,所以并非没有界限。最终,你会用尽了宇宙中的所有能量和所有原子来构建计算设备。但相对于目前来说,实际上可以视作是无限的。超越人类智能,这个范围是很广的。

斯蒂芬·霍金担心机器智能会产生可怕的意外后果。你有类似的担心吗?

比起这个,我更担心人类智能的意外后果,比如气候变化、病原体、大规模贫困和环境灾难。

对AI的追求应该带来新技术、更深入的理解和更明智的决策。AI有朝一日可能成为我们避免此类灾难的最佳工具。但是,我们应该谨慎行事,制定明确的规则,禁止不可接受的AI应用,例如禁止开发自主武器。

现在,你通过游戏AI的成功应对了这些巨大的挑战,但有没有失望过?

嗯,监督学习已经产生了巨大的主流影响。大多数来自谷歌的大型应用程序都在系统的某个地方使用监督学习。

目前我的一个失望是,我们还没有发现通过强化学习对自学习系统产生这种程度的影响。在未来,我希望看到能够在虚拟世界中以真正实现我们目标的方式与人互动的自学系统。例如,一个为自己学习实现目标的最佳方式的数字助理。那将是一个美丽的成就。

你有工作的个人目标吗?

在与李世石的AlphaGo比赛中,我走到比赛场地外,发现一个围棋选手哭了。我以为是在难过,但实际上他并没有。

在这个他全心投入的领域,AlphaGo 正在下出他从之前未意识到的棋。这让他感受到了一种深刻的美感。

以我的围棋水平,还不足以完全体会到这一点。但我们应该努力在能感觉到的一切地方都建立类似的智能。

我认为应该这样开发AI智能,不是因为AI做了什么或AI给我们的帮助多么多么大,而是因为,智能本身就是一件很美丽的事情。